こんにちは。TATです。

今日のテーマは「スクレピングとは何か?」です。

スクレイピングってなんだろう?ウェブからデータを収集する技術であることは聞いたことあるけど細かいことはよくわからない。どんな場面で活用できるのだろうか・・・

上記の疑問に答えていきます。

本記事の信憑性

スクレイピングは、ウェブ上にあるデータを抽出する技術のことを指します。

スクレイピングを使えば、ウェブ上にある大量の情報の効率的に収集することができ、そのデータをビジネスや研究などに活用することができます。

業務効率化の観点でもスクレイピングは便利です。

マニュアルでウェブサイトから情報を収集する場合、1つ2つなら問題ありませんが数百個、数千個になってくると大変な作業になってきます。

スクレイピングを活用すればこういった作業を自動化でき、さらに定期的に実行すれば日々の業務を完全自動化することも可能です。

情報の価値が高まりつつある現在の情報社会においては、いかにたくさんの価値ある情報を収集できるかが重要になってくる場面があります。

スクレイピングの技術があればこういった場面で優位に立つことができます。

本記事では、スクレイピングについて紹介します。

スクレイピングとは何か、スクレイピングで何ができるのか、さらにスクレイピングを関連の強いPythonについても紹介していきます。

この記事を読んでいただくと、スクレイピングの基本を理解することができ、スクレイピングを実践するために必要なプロセスがわかります。

スクレピングについて知りたい、スクレピングを勉強してみたい、という方は是非とも最後まで読んでいただけると嬉しいです。

目次

スクレイピングとは何か?

まずはスクレイピングについて紹介していきます。

スクレイピングとは、広義にはデータを収集して整理する作業のことを指します。

ただし、ここでは特にWebスクレイピングについて焦点を当てて紹介していきます。

Webスクレイピングとは?

Webスクレイピングとは、インターネット上のウェブページから情報を自動的に取り出す技術のことを指します。

実際の工程では、プログラムがウェブサイトを巡回し、HTMLやCSSなどのコードを解析してデータを抽出します。

これにより、大量のウェブページから情報を効率的に収集することが可能になります。

スクレイピングで何ができるのか

次にスクレイピングの利用例を紹介します。

スクレイピングを使うと、具体的にどんなことができるのでしょうか。

データ収集

スクレイピングを利用する最大のメリットはやはりデータ収集です。

手動で大量のデータを集めるのは大変ですが、スクレイピングを活用すれば効率的に収集することができます。

例えば、株式投資の場面では、株価データや業績データなどをスクレイピングで収集して、それらを活用して投資判断を下すことができます。

-

Pythonを独学して株式投資に必要な情報を管理するサイトを自作したお話。

続きを見る

また、不動産業者であれば、複数の物件の情報を収集し、適正価格を判断することが可能です。

-

【Pythonで不動産データ分析!】機械学習(ランダムフォレスト)を用いてSUUMOからお得物件を探してみた!

続きを見る

市場調査

市場調査もスクレイピングを活用できる場面の1つです。

商品やサービスの評価や価格、ユーザーのフィードバックなどを収集し、市場の動向を把握することが可能です。

例えば、新商品を開発する際に、同じカテゴリーの既存商品の評価や価格、ユーザーフィードバックを収集し、それを基に商品開発を進めることが可能です。

データ分析

データ分析のためにスクレイピングでデータを収集することはよくあります。

収集したデータを分析することで、新たな知見を得ることができます。

特にビジネスにおける用途は多いです。

データを活用して判断することをデータドリブンといったりもしますが、こういった判断を行うためにはきちんとデータを見て判断することが大事です。

例えば、スクレイピングで収集したユーザーレビューや評価データを分析し、商品やサービスの強みや弱み、改善点を発見することが可能です。

スクレイピングを使えば、こういった分析・判断のために必要なデータを効率的に収集することができます。

-

【禁断の比較】食べログとGoogleのレビューデータを比較する【Pythonでデータ分析】

続きを見る

オートメーション

そして最後に、日々の繰り返し作業を自動化することも可能です。

ログイン操作、フォームの入力、ボタンのクリックなどの一連の操作を自動化することで、作業効率を大幅に向上させることができます。

例えば、毎日定時にウェブサイトの情報を確認する必要がある場合、その作業をスクリプト化し、自動化することが可能です。

日々の繰り返し業務から解放されることで、少し早く帰宅することもできますし、空いた時間を使って別の業務を行うこともできます。

このように、スクレイピングはたくさんの場面で活用することができます。

日々の作業を効率化することができるので、スクレイピングのスキルを持っておくと重宝される場面がたくさんあります。

スクレイピングの注意点

スクレイピングはさまざまな用途に利用できるとても強力な技術ですが注意点もあります。

ここで、スクレイピングを行う際に注意すべき点について簡単にまとめます。

スクレイピングを行う際の注意ポイント

- 著作権

- 個人情報の扱い

- 利用規約

- サーバーへの負荷

きちんとルールを守って行うことが大切です。

著作権

1つ目は著作権です。

基本的に、自分自身の業務効率化を目的としている場合や分析のための情報収集などについては問題なしとされています。

ただし、収集したデータをそのまま第三者に提供するとか、取得したデータをそのまま利用する場合には注意が必要です。

個人情報の扱い

収集する情報に個人情報が含まれている場合には注意が必要です。

個人を特定可能な情報を含むデータをスクレイピングする場合、データ保護法に違反する可能性があります。

個人情報が含まれているようなデータはスクレイピングしない方が無難です。

利用規約

スクレイピングを行う際には、サイトの利用規約も確認する必要があります。

サイトによっては、「スクレイピングを禁止する」と利用規約に明記している場合もあります。

この場合、スクレイピングするのはアウトです。

スクレイピングする際にはきちんと確認するようにしましょう。

サーバーへの負荷

最後にサーバーへの負荷も考慮しましょう。

利用規約に「スクレイピングの禁止」との記載がなくても、「サーバーに過度な負担を与える行為を禁止とする」みたいな書き方がされている場合も結構あります。

この場合、スクレイピングはアウトではありませんが、サーバーへの負荷は考慮しなくてはいけません。

一度に大量のリクエストを送るようなやり方は避けるべきです。

基本的に、いかなるサイトをスクレイピングする場合においても、このサーバー負担を考えたプログラムを設計することが大切です。

やりすぎるとアクセスブロックされる場合もありますので気をつけてください。

Pythonとスクレイピング

次にプログラミング言語の1つであるPythonについてご紹介します。

スクレイピングを行う際には、プログラムを書く必要があります。

実際にはOctparseなどのサービスを使えば、ノーコードでもスクレイピングができてしまうのですが、より自分専用に自由に設計したい場合はプログラミングのスキルが必要になってきます。

プログラミング言語はたくさんありますが、スクレイピングをするにあたってダントツでおすすめなのがPythonです。

Pythonとは?

Pythonはプログラミング言語の1つです。

他のプログラミング言語に比べて、読みやすく、短くて簡潔なコードを書くことが可能な言語で、プログラミング初心者でも比較的学びやすい言語とされています。

Pythonはスクレイピングの他にも、データ分析やAI、ウェブ開発など、さまざまな用途に活用できます。

スクレイピングによるデータの収集、分析、可視化、さらにはAIの実装など、あらゆる用途に対応できることから、Pythonの需要は世界中で高まりつつあります。

-

【人気上昇中】今人気のプログラミング言語「Python」は何ができるのか?できることまとめます【転職でも有利です】

続きを見る

Pythonがスクレイピングに適している理由

次にPythonがスクレイピングに適している理由をご紹介します。

以下の通りです。

Pythonがスクレイピングに適している理由

- シンプルさ: Pythonはシンプルで直感的な構文を持っているため、初心者でも学びやすいのが特徴です。その結果、スクレイピングの初歩を習得する際の学習曲線が緩やかになります。

- 強力なライブラリ: PythonはBeautifulSoup, Scrapyなどのスクレイピングに特化したライブラリが豊富に用意されています。これらのライブラリを活用すれば、短いコードでスクレイピングを実装することができます。

- コミュニティ: Pythonのコミュニティは大きいです。わからないことがあってもGoogleなどで検索すればすぐに答えが見つけられるのもメリットの1つです。

1番の理由は、スクレイピングに特化したライブラリが豊富なことにあると思います。

BeautifulSoupやScrapyなどのライブラリを活用すると、短いコードでHTMLを簡単に解析することができ、任意の情報を自由に抽出することができるようになります。

Pythonの学習

Pythonは数あるプログラミング言語の中でも比較的学びやすいと言われています。

構造がシンプルで、比較的短いコードで複雑な処理にも対応できるのが魅力です。

Pythonでスクレイピングを実装するためには、Pythonの最低限の知識と、スクレイピングに必要なPythonライブラリの理解が必要です。

さらにはHTMLやCSSの構造についても理解しておくと、スクレイピングがスムーズに実装できるようになります。

スクレイピングを実装するために必要な知識

- Pythonの基礎的な知識(文法など)

- スクレイピングに必要なライブラリの理解(requests, Beautifulsoup, scrapy, seleniumなど)

- HTMLやCSSの理解(読んで理解できればOK)

これらの知識を学ぶにはいろいろな方法があります。

プログラミングスクールを活用するのもありですし、Udemyなどの動画学習サイトを利用するのもありです。

-

【これから学ぶ方へ】Pythonのおすすめ勉強法をまとめます!

続きを見る

-

プログラミングの独学にUdemyをおすすめする理由!【僕はPythonを独学しました】

続きを見る

Pythonでスクレイピングを実行する

次にPythonを使用してスクレイピングを実行するまでの流れについてご紹介していきます。

Pythonを使用したスクレイピングの流れ

まずは全体の流れを確認しましょう。

Pythonでスクレイピングを行うまでの流れ

- ライブラリのインポート: 最初に、スクレイピングに必要なライブラリ(requestsやBeautifulSoup等)をインポートします。

- ウェブページのダウンロード: requests.get()関数を使用して、指定されたURLのHTMLをダウンロードします。

- HTMLの解析: BeautifulSoupオブジェクトを作成してHTMLを解析し、データ抽出の準備をします。

- データの抽出: BeautifulSoupのメソッド(find(), find_all(), など)を使用して必要なデータを抽出します。

- データの保存: 最後に、抽出したデータをファイル(CSVやテキストファイルなど)に保存します。

簡単なスクレイピングを実行してみる

実際に簡単なスクレイピングを実行してみましょう。

実際のコードを見ると、かなり短いコードでスクレイピングが実装できるということが実感いただけると思います。

ここでは簡単な例として本サイト「気ままなブログ」のトップページをスクレイピングして、サイトのタイトルを取得してみることにしましょう。

必要なライブラリのインストール

まずはライブラリのインストールです。

Pythonでスクレイピングを行うためには、requestsとbeautifulsoup4(bs4)という2つのライブラリが必要です。

次のコマンドでこれらのライブラリをインストールするには以下のコマンドを使用します。

Pythonはすでにインストールされている前提です。

pip install requests pip install bs4

これで必要ライブラリをインストールすることができます。

ウェブページからのHTMLの取得

次にウェブページからHTMLを取得します。

今回の対象とするサイトは本サイト「気ままなブログ」です。

HTMLを取得するためには以下のコードで実行できます。

from bs4 import BeautifulSoup import requests # urlを定義 url = "https://myfrankblog.com" # htmlの取得 r = requests.get(url)

これで指定したURLのHTMLを取得できます。

requests.get(url)は指定したURLからHTTPリクエストを送り、サーバーからのレスポンスを受け取ることができます

HTMLの解析

次に、取得したHTMLを解析します。

HTMLの解析にはbs4のBeautifulSoupを使います。

# htmlを解析 soup = BeautifulSoup(r.content, "html.parser")

これでBeautifulSoupクラスのインスタンスが作成されて、さまざまなデータにアクセスすることができるようになります。

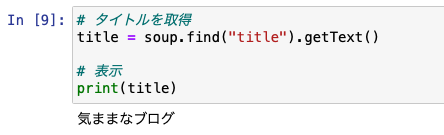

データの抽出

解析したHTMLからデータを抽出します。

ここでは例としてサイトのタイトルを取得してみます。

# タイトルを取得

title = soup.find("title").getText()

# 表示

print(title)

確認すると、サイトのタイトルがきちんと取得されていることがわかります。

簡単ですよね。

こんな感じで、BeautifulSoupを使うといろいろなデータを抽出することができます。

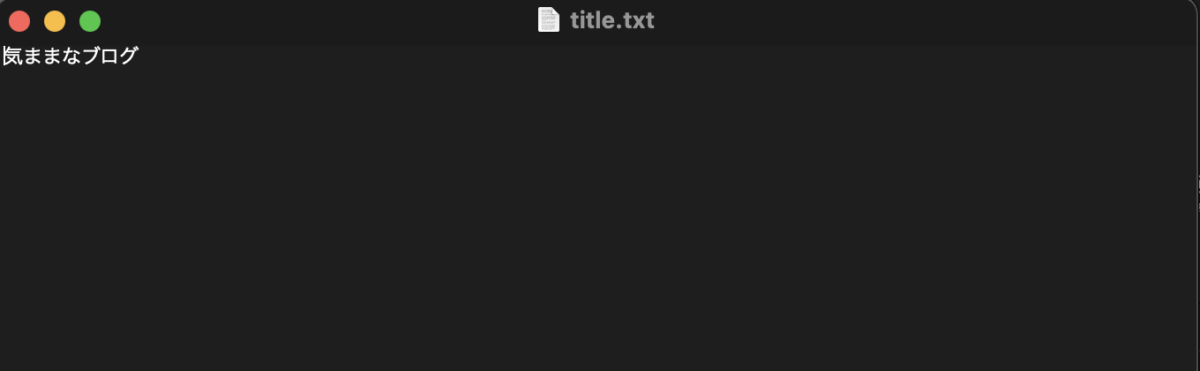

データの保存

最後に、抽出したデータを保存します。

Pythonのライブラリには、データをファイルに保存するための便利な関数が多数含まれています。

ExcelやCSV形式で保存したり、バイナリデータをとして保存したり、テキストファイルとして保存したり、いろいろな方法でデータを保存することができます。

ここでは例としてテキストファイルに保存してみます。

# テキストファイルに保存する

with open('title.txt', 'w') as f:

f.write(title)

きちんとファイルに保存されていることが確認できます。

これはかなり簡単な例ですが、このような感じで、比較的に少ないコートで簡単にスクレイピングを実装することができるのがPythonの特徴です。

基本的には、必要なライブラリが揃っているので、それらを組み合わせることにより、より複雑なデータも取得することができます。

スクレイピングの具体例

スクレイピングを使った具体例を本ブログで紹介している記事から紹介します。

岸田首相の「検討」の発言回数を集計したり、SUUMOのデータを収集して最適な賃貸物件を探したり、価格.comのデータから中古車データを収集して分析したり、いろいろなことをしています。

-

国会の議事録データを収集して岸田首相の「検討」の発言回数を集計してみた【Python】

続きを見る

-

【Pythonで不動産データ分析!】SUUMOをスクレイピングして情報収集!理想の賃貸物件を探してみた!

続きを見る

-

【Pythonコード解説】価格.comをスクレイピングして中古車データを収集する

続きを見る

これらはただの一例に過ぎないので、詳しくは本サイトで「スクレイピング」と検索してみてください。

結構ふざけた分析記事もたくさんありますw

応用的なスクレイピングテクニック

スクレイピングの基本を身につけたら、より応用的なテクニックにも挑戦してみましょう。

Pythonなら動的なウェブページのスクレイピング、ページネーションなど、複雑なサイトにも対応することも可能です。

動的なウェブページのスクレイピング

現代のウェブサイトの多くはJavaScriptを使用して動的にコンテンツを生成しています。

そのため、Pythonのrequestsライブラリだけでは取得できない情報が存在します。

このような場合はSeleniumなどといったウェブブラウザを自動操作できるツールを活用すれば解決できます。

本サイトでも、Seleniumを使ったスクレイピングを紹介しています。

-

【Pythonでデータ分析】株クラで目にする「おはぎゃー」のプロセスを自動化してみた!

続きを見る

ページネーション

多くのウェブサイトは大量の情報を持っていて、一つのページに全ての情報を表示することはできません。

そこで情報は複数のページ(ページネーション)に分けて表示されます。

ページネーションを持つウェブサイトから情報を抽出する場合、各ページのURLを順にスクレイピングするか、あるいはSeleniumのようなツールを使って「次へ」ボタンを自動的にクリックすることで全てのページから情報を取得します。

-

【Pythonコード解説】Seleniumで国会会議録検索システムをスクレイピングしてみる

続きを見る

ログイン処理

Seleniumを使えば、サイトへのログイン処理も実装可能です。

ログインして情報を取得したり、SNSで自動いいねとつけたりといろいろな用途に活用できます。

-

【Python】SeleniumでSBI証券に自動ログインする方法【自動売買への道】

続きを見る

-

【Pythonコード解説】SeleniumでInstagramの自動いいね!をしてみる

続きを見る

結論:Pythonを学習してスクレイピングを活用しよう!

スクレイピングを利用すると、ウェブから大量の情報を効率的に収集することができます。

これにより、普段の作業を効率化したり、収集したデータを分析してビジネスに活用したり、いろいろな場面で利用することができます。

スクレイピングが活躍できる場面は結構あるので、スキルとして持っておくと結構重宝されます。

スクレイピングを行うにはPythonの基礎的な知識と、スクレイピングに必要なライブラリ(requestsやBeautifulSoupなど)の知識が必要です。

Pythonは、スクレイピング以外にもデータ分析やデータの可視化、AIの実装やウェブサイト開発など、さまざまな用途に利用できることから需要が増加しています。

他のプログラミング言語に比べて比較的学びやすいことも特徴の1つです。

もし本記事を読んで、スクレイピングやPythonに興味が出たら是非ともチャレンジしてみてください。

本記事がみなさんの参考になれば幸いです。

最後まで読んでくださり、ありがとうございました。